企业大模型安全防护指南(含工具选型)

越来越多的企业开始使用大模型来辅助办公、客服和研发,AI正在成为日常工作中的得力助手。然而,AI应用中也隐藏着不少安全风险。

斯坦福大学的学生曾通过对话成功让Bing Chat泄露了内部代号“Sydney”及其行为规则——这并非个例。这类事件提醒我们:大模型是数字时代的“效率引擎”,但如果缺乏安全防护,也可能变成“风险炸弹”。

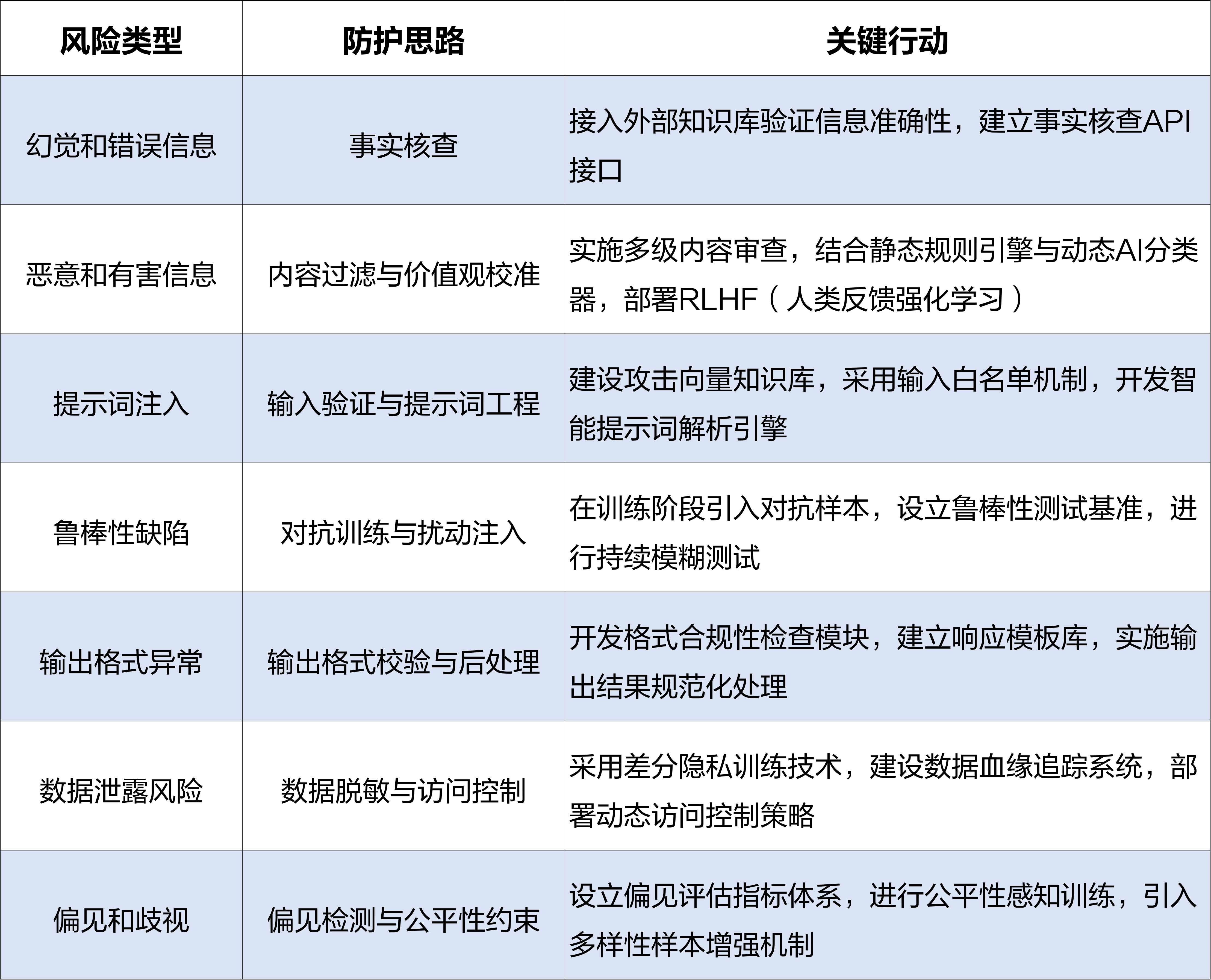

企业大模型最容易踩的7个雷

1、幻觉和错误信息:大模型可能生成看似专业、实则虚假的内容。例如,编造报告数据,导致决策失误。

2、恶意和有害信息:如果缺乏过滤机制,大模型可能输出暴力、仇恨和煽动性言论,给企业形象和用户带来伤害。

3、提示词注入:通过特殊输入,绕过内容限制。例如,在代码生成场景中,黑客在注释中藏入恶意指令,让AI生成带后门的代码。

4、鲁棒性缺陷:大模型对输入的微小变化敏感。同样的问题,略微改几个字,AI的答案可能天差地别,在企业严谨场景中引发混乱。

5、输出格式异常:大模型输出不符合预设格式,影响系统对接和用户体验。在系统集成时尤为棘手,可能引发一系列兼容性问题。

6、数据泄露风险:大模型可能在无意中泄露训练数据中的敏感信息。例如,某公司训练数据中包含客户身份证号,AI在回答特定问题时完整复现了这些信息。

7、偏见和歧视:大模型可能吸收并放大训练数据中的歧视,导致不良影响。

如何构建企业大模型的安全防线?

面对上述七类风险,关键是搭建精准防御体系。下方表格是可直接落地的防护策略:

一套完整的防御体系,核心包含三个部分:

· 攻击模拟器:内置200+攻击模版,能模拟提示词注入、越狱攻击等12类威胁场景,每天自动生成10w+测试用例,全面检验大模型防御能力。

· 漏洞检测引擎:静态检测大模型权重、注意力机制等底层特征;动态监控实时行为,通过异常检测算法识别可疑输出。

· 风险评估中心:从内容毒性、隐私泄露风险、偏见指数等18个维度量化风险,生成可视化评估报告,一目了然掌握AI安全态势。

这套防御体系还能融入企业的DevSecOps流程,对大模型开发、测试、部署全程进行安全管控,达成事前预防的目标。

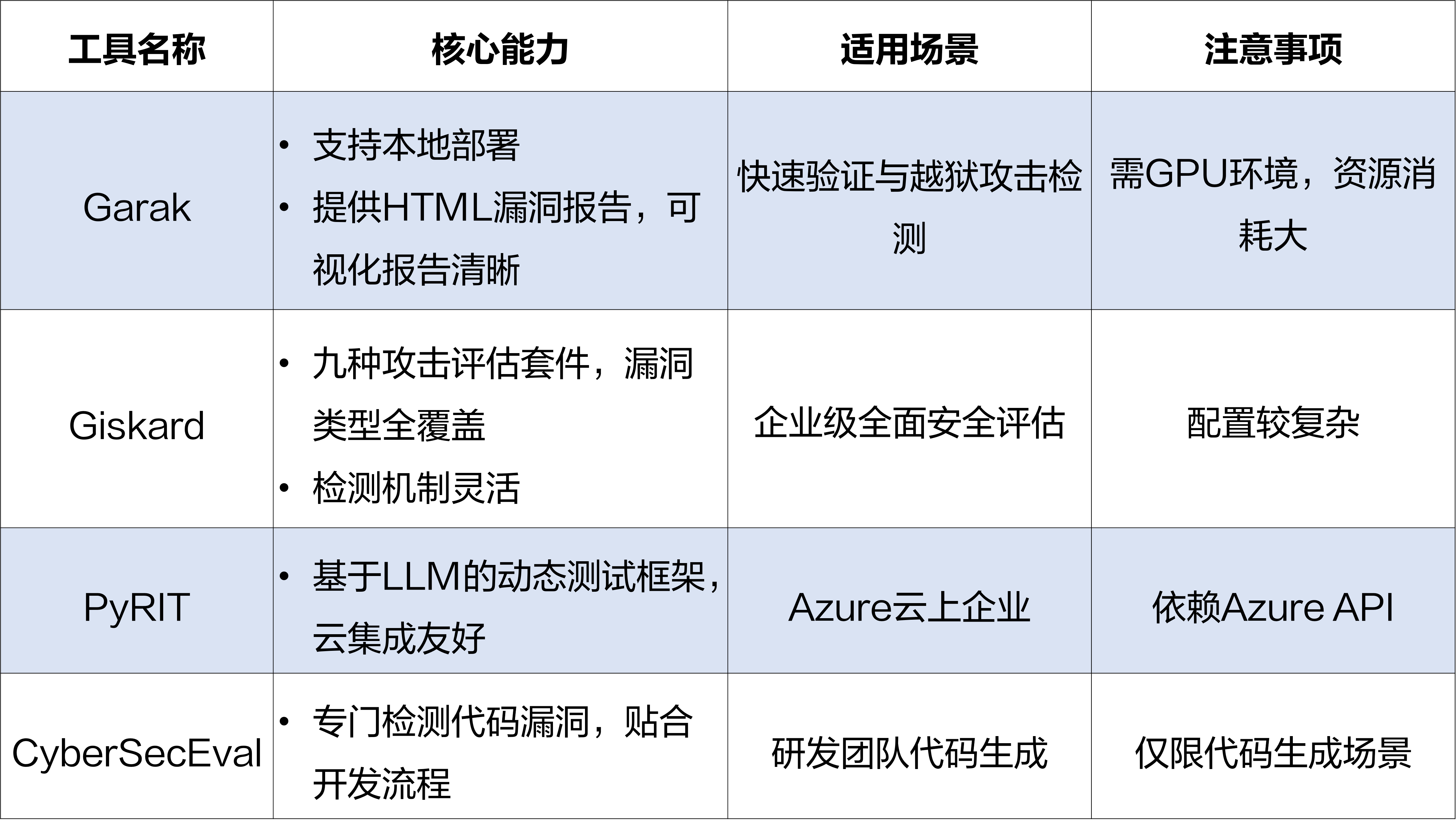

主流开源安全工具选型

快速选型Tips:

1、快速验证:选Garak,开箱即用,适合POC测试,半天就能上手。

2、全面检测:选Giskard,混合检测机制,可覆盖超90%漏洞类型。

3、云原生环境:选PyRIT,与Azure生态深度集成,适合云上企业。

4、代码安全:选CyberSecEval,在OWASP Top10漏洞检测中表现优异。